Einstieg

Anfang des Jahres hatte ich mich zum grossen Vergleichstest der KI Chatbots bemüht. Was ich damals noch nicht wusste war, wieviel Neuigkeiten ich schon verpasst habe. Und jetzt ist es so, dass mittlerweile täglich neue Sensationen veröffentlicht werden. Die Technologie hat eine atemberaubende Geschwindigkeit aufgenommen und es ist schwer, da mitzuhalten. Oder wenigstens den Überblich zu behalten. Denn man kommt aus dem Staunen nicht mehr raus. Unglaublich, was heutzutage alles möglich ist und welche Wege sich eröffnen. Deswegen schauen wir nochmal in die KI Werkzeugkiste.

Natural Language Processing (NLP)

Im Chatbot Vergleich ging es um Verarbeiten natürlicher Sprache und das natürlich als Text. Diese Sparte in der KI heisst Text Generation oder Question Answering. Üblicherweise fragt man den Chatbot etwas und der antwortet dann darauf. Dass dies so superleicht funktioniert, liegt an intensiven Training des Large Language Models (LLM). Dabei kann dies nur erraten, was als nächstes passieren wird. Was könnte die nächste Frage sein? Was wäre die nächste Antwort? Was wäre der nächste Schritt? Deswegen bieten die meisten LLM auch eine Autovervollständigungsfunktion. Es wird schon vorgeschlagen, wie die Frage vollständig aussehen soll. Bei der Programmierung von Code werden auch ganze Programmzeilen oder Funktionen vorgeschlagen.

Das geht durch Vektoren. Die deutsche Sprache besteht zum Beispiel aus 70.000 Wörtern im täglichen Sprachgebrauch. Sich die alle zu merken, ist für einen Computer ein Klacks. Wenn man ein Wort eingibt, gibt es nur eine begrenzte Anzahl von Möglichkeiten, wie es weitergeht, also was als nächstes Wort kommt. Diese Möglichkeiten sind Vektoren und die sind unterschiedlich stark, je nach Häufigkeit im deutschen Sprachwortschatz. Nach “Ich” folgt meistens “Ich bin” oder “Ich suche”, wenn man im Kontext einer Suchmaschine unterwegs ist. Programmiersprachen sind noch einfacher. Es gibt eine Handvoll Datentypen und eine Liste von Funktionen. Die brauch man bloss in Einklang bringen, um ein bestimmtes Ziel zu erreichen.

Prompting

Der Begriff stammt eigentlich aus der Verhaltenstherapie und bedeutet soviel wie anregen, soufflieren, vorsagen. Deswegen auch der Begriff Teleprompter. Beim Chatbot befindet man sich auch an einem Prompt und kann dort auch schon loslegen. Jedoch hat man es hier nicht mit einem Wörterbuch zutun, wo man Wissen nachschlägt. Im Begriff KI besteht die Hälfte aus Intelligenz und die wird beim Prompting voll ausgelebt, indem man dem Chatbot erstmal sagt, wer er ist. Man kann die Unterhaltung etwa beginnen mit: “Agiere als intelligenter Chatbot und erzähle mir, wie Schweinebraten zuzubereiten sind”. Auch eine KI, die ohne Nahrung auskommt, wird ein paar Kochbücher gelesen haben und die passende Antwort geben. Man kann aber auch fragen “Erzöhl mir die Zubereitung des Schweinebratens aus der Sichweise des Schweins”. Nun, diesen Dialog hier generierte das ChatGPT Basismodell. Die Unterhaltung ist zwar auf englisch, hätte aber auch mühelos auf deutsch geführt werden können.

Eine andere Methode ist das Chaining, die Verkettung von Fragen und Antworten. Die meisten Chatbots haben das automatisch eingebaut, indem sie die Unterhaltung zwischenspeichern und dann in dem “Thread” beliebig den Faden wieder aufnehmen können. Wenn man selbst nicht kreativ ist, kann man auch den Chatbot fragen, welche Fragen denn zu diesem oder jenem Thema angebracht wären.

Beliebt ist auch die Gliederungserweiterung. Aufgrund von Eingaben soll eine Gliederung mit Aufzählungspunkten erstellt werden. ChatGPT soll immer nach dem nächsten Punkt fragen. Dabei verliert die KI auch schon mal den Faden. Deshalb sollte man die KI fragen, dass sie uns fragen soll, was wir am Ende erreichen wollen. Auch hier gerne nochmal ein Schweinebratendialog.

Und wem das alles zu fettig ist: Man kann ChatGPT auch seine Krankengeschichte erzählen und die Medikamente, die man nimmt. Die Beipackzettel liest sowieso niemand, ChatGPT kennt aber die Zutaten und kann überflüssiges entfernen.

Apropos: Auch aus E-Mails, die man ChatGPT vor den Prompt wirft, kann die KI bitten, diese zu filtern und überflüssige Informationen entfernen.

Der Kreativität sind da keine Grenzen gesetzt. Es gibt schon Interessengruppen, etwa auf meetup.com, die sich über Möglichkeiten austauschen. Was passiert zum Beispiel, wenn sich eine KI mit einer anderen unterhält?

LMArena

Herauszufinden, welches LLM jetzt am besten zu seinen Bedürfnissen passt, kann schon eine Herausforderung sein. Auch wenn weiter ChatGPT der Platzhirsch bleibt, gibt es noch einige mehr Chatbots online:

Der Copilot wirkt für mich derzeit am Dümmsten. Auf Github findet er seine eigenen Repos nicht und auch sonst scheint er gerade an einer rätselhafte Krankeit zu leiden. Dabei hat Microsoft grosses mit ihm vor. Er soll in alle Office-Produkte integriert werden, so etwa helfen, bessere E-Mails zu schreiben. Oder bei Teams-Meetings das Protokoll zu führen, das Wichtigste zusammenzufassen und automatisch Aufgabenlisten zu erstellen.

Wer Chatbos vergleichen will, findet in der LM Arena eine gute Plattform. Dort gibt es auch immer die neuesten Chatbots zum Ausprobieren.

Unzensierte LLM

Man hat es vielleich schon gemerkt: Bei manchen Themen ist bei ChatGPT einfach Sense. Keine Antwort zu bösen Schimpfwörtern, Bombenbauanleitungen oder sonstige anrüchige Themen, als wenn das Internet nicht mehr zu 90% aus Porno bestehen würde. Aber wie auch Google Search dieses Thema erfolgreich rausfiltert, bleiben auch die Chatbots brav und vermitteln eine heile, freundliche Welt. Böse Zungen behaupten, die LLM prompten den Nutzer und nicht umgekehrt. So drastisch ist es nicht, aber es ist etwas dran. Empfohlen ist der Blogbeitrag von Eric Hartford. Von ihm stammen die Dolphin-LLM, die auch im Video AI mit Arnie beschrieben und vorgeführt sind. Bei der Erstellung von LLM werden Stopwords eingefügt. Also so wie früher bei der Suchmaschine gibt es eine Liste von Wörtern, bei der nicht weitergesucht werden soll. Erix Hartford hat diese Wortlisten gelöscht und die LLM neu gepackt. Wenn man auf Ollama nach Dolphin sucht, findet man zu jedem Model einen Pedanten von ihm. Kann jeder selber ausprobieren. Das voreingenommene Verhalten oder das Trainieren in eine Richtung wird auch Bias genannt.

Deep Research

Das Thema will ich nur kurz ansprechen und auf den Youtube-Kanal von The Morpheus verlinken. Er beschäftigt sich ausgiebigst mit dem Thema und beleuchtet auch immer die moralischen Aspekte. Hier geht es um die Recherche zu einer kompletten Bachelor-Arbeit, von der KI geschrieben in wenigen Minuten.

Zwischen Deep Research und dem Prompting steht auf dem Zeitstrahl der Antwortzeiten noch das Reasoning. Hier versucht das LLM logische Schlüsse zu ziehen, also nicht nur abgespeichertes Wissen abzurufen wie bei einem Wörterbuch.

Agenten

Auch bei Agenten, oder auch Operatoren genannt, verweise ich auf The Morpheus. In diesem Video wurde die Arbeitsweise des ersten Agenten erklärt. Im Prinzip soll das so funktionieren: Prompt: Stelle mir eine Reise zusammen für 2 Personen im Sommer nach Polen und viel Erholung. Und dann arbeitet der Agent die Reiseroute aus, bucht die Hotelzimmerr und stellt die komplett ausgearbeitete Reiseplanung incl. aller Sehenswürdigkeiten zur Verfügung Man muss bloss noch hinfahren. Verwiesen sei auch noch auf Genai, ein Katalog von Chatbots und Agenten.

Computer Vision

Mit Vision ist hier jegliche Art von Visionalisierung gemeint, Bilder, Videos, Grafiken, die ich mit KI erstellen oder verändern kann. Fangen wir mal mit dem Google AI Studio an und dem frei zugänglichen Gemini 2.0 Flash in der Beta-Phase. Man kann am Prompt allmögliche Bilder hochladen, oder sich direkt mit Google Drive verbinden und dann der KI sagen, was es mit den Bildern machen soll. Also am einfachsten: schöner, besser, neuer, älter, futuristischer. In Landschaftsbildern kann ich sagen, dass es schneit, regnet, oder Wasser über eine Strasse fluten lassen. Äh, wie geil ist das denn? Mit Photoshop bin ich ja nie warm geworden. Vielleicht fehlt mir auch das künstlerisch, grafische Verständnis. Brauch man jetzt gar nicht mehr. Einfach sagen, was los ist. Apropos: Statt Texteingaben kann man mit Gemini auch “reden”. Es ist dieselbe KI, die auf Android-Handys mit ausgerollt wird.

Ich habe Gemini 2.0 Flash dazu verwendet, mit ein Bild von einem Boot in Frontansicht zu generieren, von dem ich nur eine Seitenansicht hatte. Kein Problem, Gemini rechnet das für Dich aus.

Andere Dienste von Text zu Image sind noch

Es gibt inflationär viele Dienste, die entweder komplett kostenlos funktionieren oder eine Free-Trial-Phase haben. Kommerziell ist es schwer, hier Fuss zu fassen, wenn die Konkurenz immer mehr vermeintliche Premiumfeatures für umsonst anbietet.

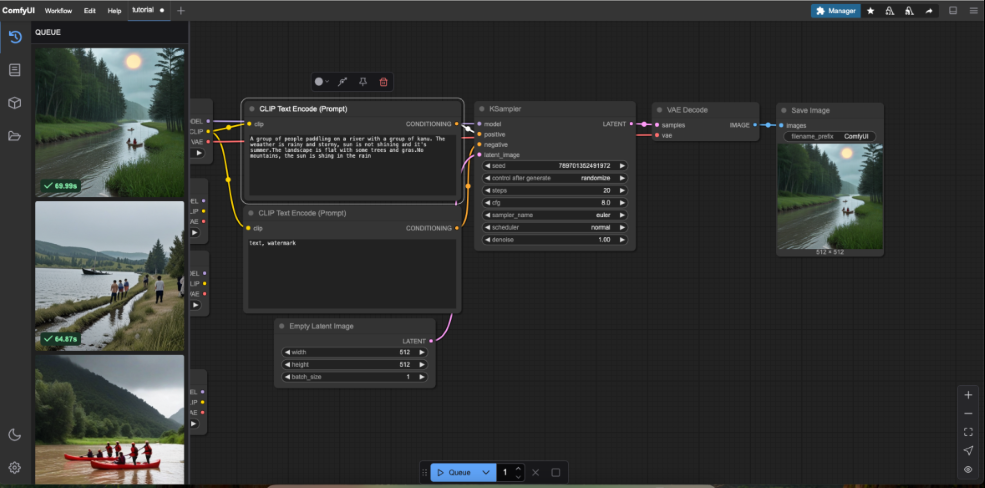

ComfyUI

Ein anderes Werkzeug ist ComfyUI. Das ist tatsächlich ein Programm, was man sich herunterladen und installieren muss. Nach dem Start wird man von der Oberfläche erschlagen.

Aber es ist gar nicht so schlimm. Im Prinzip ist es ein Workflow, auch Pipeline genannt, wie ein Bild generiert wird. Als erstes brauchen wir auch hier ein Model. Das muss aber kein LLM mit breitem, komprimierten Wissen sein. Hier steht die Kreativität im Vordergrund. Schauen wir mal auf CivitAI. Dort gibt es zahlreiche Fantasiewesen, aber auch cyberrealistische Models, die wir verwenden können. Die meisten sind kostenfrei zu nutzen, es gibt aber auch Kaufmodelle, denn klar - mit KI wollen einige Leute auch Geld verdienen. Bei den kreativen Model mach das auch Sinn, wenn jemand dort Zeit und Geld investiert hat, um das Model zu trainieren. Aber es muss kein fertiges LLM sein, hier reichen schon Datasets, oder auch Dimensions genannt. Das sind Checkpoint Versionen von Models. Es reicht hier die Tensorflow-Datei herunterzuladen und im ComfyUI links als Model hinzuzufügen. Weitere Quellen für Datasets:

- Huggingface

- WanVideo

- FreePic

- KREA

- Tensorart

- PixAI

- Midjourney - only paid services

Nicht bei allen kann man Datasets herunterladen. Viele wollen auch Nutzer auf deren Plattform binden. Natürlich mit Abos oder anderen Bezahlmodellen. Fair genug, wenn man denkt, dass ein unbedachter Mausklick oder Anfrage an eine Prompt immense Rechenleistung auf einem GPU-Server beim Betreiber verursachen kann.

Deswegen auch der Hinweis auf ComfyUI und dem Selberbetreiben. Denn nach der Auswahl des Models, brauch man in der Textbox nur noch eine Textbeschreibung eingeben, wovon das Bild handeln soll und klick, schon läuft die Pipeline los und gibt rechts das fertige Bild aus. Für ein anderes Model muss man nur die bunten Linien in der Pipeline passend verbinden und schon generiert man mit einem anderen Model. Und was die Motive angeht: Wir nutzen unsere eigene Infrastruktur, unzensiert. Man kann zum Beispiel auch Nacktbilder generieren lassen - natürlich nur von sich selber.

Audio

Text to Speech, Text to Audio, Audio to Audio - hier dreht sich alles um den Ton. Ob eine KI gesprochenes Wort aufnimmt und übersetzt oder einen Text vom Prompt in einen Ton umwandelt - sei es, dass eine Stimme einen Text vorliest. Oder man Geräusche per Text beschreibt: Plätscherndes Wasser am Boot und die KI dazu den Ton generiert.

ElevenLabs

Eine KI-Plattform der besonderen Güte ist hier ElevenLabs, die kürzlich ihre Partnerschaft mit der Deutschen Telekom bekanntgaben, was ja bestens zusammenpasst, denn mit der Telekom kann man telefonieren, hat also mit Sprache und Audio zutun. Audio soll auch der Schlüssel zur KI sein, wenn man nur an die ganzen Sprachassistenten denkt, die es schon so gibt. Auch so manche Hotline hat “Call-Agenten” im Einsatz, die den Kunden erstmal eine Weile hinhalten, die Stammdaten abfragen und das Anliegen erfassen. Die Grundidee beschrieb der Gründer der Firma, ein gebürtiger Pole, so: Im polnischen Fernsehen gibt es nur unsynchronisierte Spielfilme. Die KI soll helfen, dieses Problem zu lösen. Und es stimmt! Im polnischen Fernsehen werden amerikanische Spielfilme entweder gar nicht synchronisiert oder nur mit einer monotonen Nachrichtensprecherstimme. Man kann sich das in Deutschland gar nicht vorstellen. Deswegen gibt es bei ElevenLabs verschiedene Sprachmodelle. Also sei es ein alter amerikanischer Cowboy, mit entsprechender Stimme. Oder, jetzt neu, wahrscheinlich wegen des Crowdfunding durch die Deutsche Telekom auch deutschsprachige männliche und weibliche Modelle, die jeder kostenlos nutzen kann. Denen kann man Text vorlesen lassen. Als Idee gibt es hier zum Beispiel ein Podcast, dem man ein Manuscript vorlesen lässt. Bei der Spielfilmsynchronisation helfen dann Workflow-Tools wie N8N, die den Ton des Films original im Eingang haben und dann den Film mit entsprechenden Models je nach Darsteller synchronisieren. In Echtzeit. Beim Podcast kann man sein eigenes Model verwenden, wegen der Länge ist das aber auch nur im Bezahlabo möglich. Dafür kann man das Quellmaterial in verschiedenen Formaten hochladen, oder es gleich online von einer Webseite beziehen, also quasi Blog2Podcast.

Riffusion

Ein weiterer ausserordentlicher Dienst ist Riffusion. Diese KI erstellt Lieder. Man schreibt etwa am Prompt: Erstelle mir ein Hardrock-Song, der von der DevOps Arbeit und dem täglichen Kampf mit Jira-Tickets handelt. Das dauert, schwups, und schon stehen 2 Varianten von Liedern zur Verfügung. Und was soll ich sagen: Das klingt nicht mal schlecht. Man kan ein Lied auswählen, das noch weiter verfeinern und Remixe erstellen. Zum Lied gibt es den fertigen Songtext (man könnte aber auch einen eigenen Text hinterlegen), die Tonspuren lassen sich separat herunterladen: Sänger, Schlagzeug, E-Gitarre. Das Ergebnis kann man dann veröffentlichen, oder sich privat zu Hause anhören. Momentan ist der Dienst noch kostenlos, die Nutzung des LLM und benutzte Rechenzeit dürfte alsbald kostenpflichtig werden.

Nachdem wir bis hierhin einige fantastisch neue Dienste kennengelernt haben und jeder seinen eigenen Gedanken nachhängt, hier noch ein paar kreative Inspirationen oder was mir als Anwendungsfall eingefallen ist.

Anwendungsfall: Schriftsteller

Apropos kreativ: Die Fertigstellung meines Öko-Thrillers lässt weiter auf sich warten. Vielleicht hilft mir die KI, endlich weiter zu kommen? Ich testete im Homelab Gemma3:latest, das neueste und schlankeste LLM von Google. Im Prompt wies ich das LLM an, als erfahrener Schriftsteller für Thriller zu agieren und beschrieb das Anfangsszenario des Buches und was ungefähr noch passieren sollte. In Nullkommanix hatte er den 10.000 Wörter Entwurf erstellt mit dem ersten Kapitel, der Anfangsszene, 3 Protagonisten, mit Namen, Alter, Aussehen und Fähigkeiten beschrieben und welche Situation sie gerade vorfinden. Dann wurde Kapitel 2-7 beschrieben, wie die Handlung weitergehen könnte, Kapitel 12-17, wie das Buch zum Höhepunkt kommt, und Kapitel 19, das glückliche Ende. Das Ganze wohlformatiert und in einwandfreien Deutsch,

Warum geht das jetzt so schnell? Schaut doch mal in den Artikel AI Homelab

Anwendungsfall: Sänger

Stell Dir vor, Du hast Ideen für gute Lieder. Oder andersrum: Du ärgerst Dich, warum es heutzutage keine neue Musik mehr gibt. Kein Problem mit Riffusion. Du kannst einen virtuellen Sänger kreieren, der Musik in einem bestimmten Genre macht. Die Texte kannst Du selber schreiben oder lässt diese erstellen. Dein Model läuft vollständig auf Riffusion, oder Du kannst auf Replicate das Basis-Model replizieren und trainieren. Am Ende hast Du Deine eigene Figur, die unendlich viele Lieder singen kann.

Anwendungsfall: Webdesigner

Alles was HTML ist, kann ChatGPT und andere Text-Bots heute schon als Ergebnis liefern, wenn man sie nach dem Erstellen einer coolen Webseite fragt. Die Text2Image-Models oben eignen sich hervorragend zum Erstellen von Logos oder Szenenbildern, Hintergundbildern usw. Alles was man früher mit Grafikprogrammen mit tausend Optionen und für tausend Euro nicht geschafft hat, kann jetzt die KI mit 0,nix und ohne Ahnung zu haben. Ein besonderer Dienst ist noch Websim AI, früher hätte man sowas Homepagebaukasten genannt. Am Prompt beschreibt man, was für Funktionen die Seite haben soll und wie sie aussieht und schon werden alle Dateien, egal ob HTML, CSS, Javascript erstellt und können in der Vorschau betrachtet oder heruntergeladen werden.

Anwendungsfall: Übersetzer

Der Babbelfish ist jetzt “alive”. Wenn man sich ElevenLabs anschaut, können dort per Workflow Sachen in Echtzeit übersetzt werden. Deutsche Texte werden zu englischsprachigen Podcasts, und umgedreht. Erwähnenswert ist auch, dass die meisten Chatbots jetzt auch schon Sprache automatisch übersetzen. Man kann Fragen auf deutsch stellen, ohne weiter darüber nachzudenken. Sprachbarrieren fallen, und das ist gut so. Bei Youtube zeigen Leute, wie man mit ChatGPT besser Sprachen lernen kann. Ein Thema, wo ich auf jeden Fall nochmal reinschauen werde.

Fazit

KI ist der neue PC. Früher gab es nur Grossrechner, die in abgeschotteten Rechenzentren liefen und von speziellem Personal bedient werden mussten. Die Evolution kam durch den Personal Computer, Betriebssystemen wie Mac OS oder Microsoft Windows, die auf handlichen Geräten liefen, die man mit nach Hause nehen konnte. Die KI erlebt gerade denselben Lebensweg, aber viel viel viel schneller. Klar kann man kein komplettes ChatGPT-Modell zu Hause trainieren. Da bedarf es Rechenleistung ganzer Rack-Reihen. ChatGPT beantwortet selber die Frage mit 375 Jahre, bei einer einzigen NVIDIA V100 GPU. Bei 1000 solcher GPUs dauert es wenigstens noch 34 Tage. Dennoch gibt es Mittel und Möglichkeiten, KI zu Hause zu entwickeln, etwa mit schmalen LLM oder mit Techniken wie Low-Rank-Adaption (Lora), die zum Schluss nur wenige hundert MB gross sind.

Das Schwierige ist der technische Wandel, der täglich passiert. Wenn man sich nicht täglich damit beschäftigt, verliert man einfach den Faden. Mein Vorschlag wäre, sich ein Thema herauszupicken. Vielleicht möchtest Du schon lange ein Problem lösen, etwa eine coole Webseite erstellen oder mit einem Podcast starten. Die Möglichkeiten sind dazu da.